Två domstolsbeslut i San Francisco har precis ritat om kartan för hur AI-företag får använda upphovsrättsskyddat material. Meta och Anthropic har båda fått rätt i sina tvister mot författare som ville stoppa användningen av deras böcker som träningsdata – men vägen dit har varit allt annat än rak.

Domare Chhabrias beslut i Meta-fallet

I Meta-fallet var det domare Vince Chhabria som slog fast att företagets användning av skyddade böcker faller under ’fair use’-principen. Det avgörande? Författarna, inklusive kända namn som Sarah Silverman, lyckades helt enkelt inte bevisa att de faktiskt lidit ekonomisk skada eller att AI-modellen hotar marknaden för deras verk.

Chhabria var dock noga med att poängtera att denna dom gäller specifikt denna process – framtida fall kan mycket väl få helt andra utfall.

“This ruling does not stand for the proposition that Meta’s use of copyrighted materials to train its language models is lawful. It stands only for the proposition that these plaintiffs made the wrong arguments and failed to develop a record in support of the right one.” – Domare Vince Chhabria om Meta och ”fair use”

Anthropic-fallet och domare Alsups avgörande

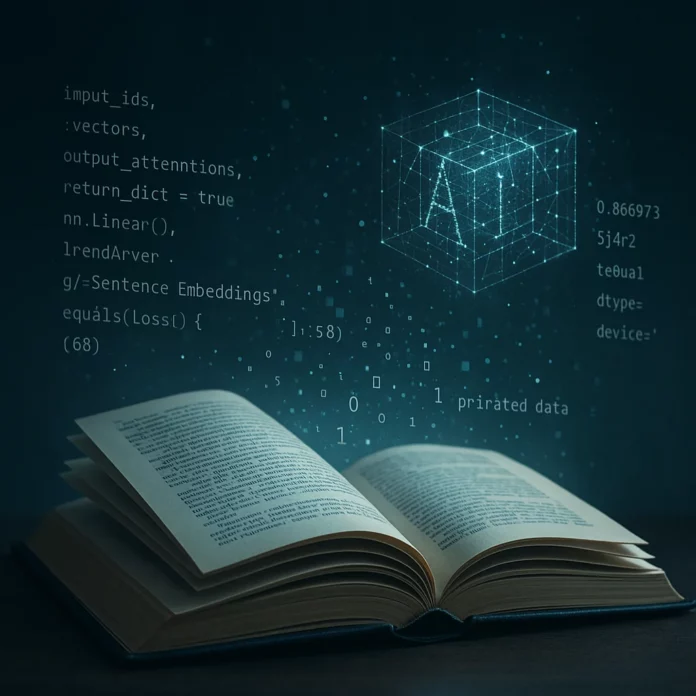

Anthropic-målet blev betydligt mer komplicerat. Domare William Alsup gjorde en viktig skillnad mellan olika typer av användning. När Anthropic tränade sin AI Claude på miljontals lagligt inköpta böcker ansåg han det vara helt okej – ett transformativt bruk som mer liknar hur en människa läser och lär sig än ren kopiering.

Men när det kom fram att företaget även använt över sju miljoner piratkopierade böcker i sin centrala databas, där drog domaren en helt annan slutsats. Det betraktades som direkt upphovsrättsbrott och ska nu avgöras i en separat rättegång.

- Meta: Användning av skyddade böcker klassas som ’fair use’ då ekonomisk skada inte bevisats.

- Anthropic: Lagligt inköpta böcker godkänns som transformativ träning.

- Piratskopierade böcker: Direkt upphovsrättsbrott, rättegång kommer separat.

- Fair use: AI:s träning ses som ett mönsterlärande snarare än kopiering.

Båda domarna bygger sin argumentation på att AI-träning är ’transformativ’ nog för att skyddas av fair use-principen. Tanken är att AI:n lär sig mönster och kunskap snarare än att bara kopiera och återpublicera originalverken. Men här börjar det bli riktigt intressant – och komplicerat.

“Like any reader aspiring to be a writer, Anthropic’s [AI] trained upon works not to race ahead and replicate or supplant them — but to turn a hard corner and create something different.” – Domare William Alsup om Anthropic och transformativ användning

Hur tränas AI – och vad menas med transformativt?

När domarna talar om att AI-träning är ”transformativ”, syftar de på att modeller inte lär sig genom att kopiera texter, utan genom att identifiera statistiska mönster. Claude, LLaMA och andra modeller skapar interna representationer (s.k. embeddings) av språkliga strukturer – inte bokstavlig lagring.

Förenklat: modellen memorerar inte boken, den lär sig hur språk i böcker brukar fungera. Men om träningen leder till att en modell kan återge hela stycken från originalverk – då är det inte längre transformativt. Och exakt var den gränsen går är fortfarande juridiskt oklart.

Komplexitet i tolkningen av transformativ användning

Frågan om vad som egentligen räknas som transformativ användning när det gäller generativ AI är långt ifrån avgjord. Olika domstolar kan mycket väl komma fram till helt olika slutsatser beroende på hur de tolkar tekniken och dess påverkan på originalverken. En central punkt är hur mycket och på vilket sätt AI-modeller faktiskt återproducerar delar av det de tränats på.

Dessa domar kommer troligtvis att bli prejudicerande för framtida fall, vilket gör dem extra viktiga för hela AI-branschen. Men samtidigt finns det redan flera liknande mål på väg upp i amerikanska domstolar, och resultaten från dessa kan mycket väl förändra rättsläget igen.

Det som gör situationen extra osäker är att lagstiftningen helt enkelt inte är byggd för den här typen av teknisk utveckling. Fair use-principen skapades långt innan någon kunde föreställa sig AI-system som kan tränas på miljoner böcker på några timmar. Därför pågår det nu intensiva diskussioner om behovet av helt ny lagstiftning, både i USA och internationellt.

Faktum är att även om dessa domar ger AI-företagen ett visst rättsligt skydd just nu, så är läget fortfarande mycket instabilt. Olika former av datainsamling, mängden kopierad text och hur AI-modellernas output faktiskt ser ut – alla dessa faktorer kan påverka framtida domslut på sätt som vi knappt kan förutse.

Vad betyder detta för svenska AI-företag?

Även om domarna i San Francisco inte är bindande i Sverige, pekar de ut en möjlig riktning som kan påverka allt från investeringar till modellval även här. Just nu saknas tydlig rättspraxis kring hur generativ AI får tränas på upphovsrättsskyddat material inom svensk jurisdiktion. Det gör att många svenska AI-startups befinner sig i ett legalt gränsland.

För företag som bygger egna språkmodeller – eller fintrimmar open source-modeller som LLaMA eller Mistral – blir frågan om träningsdata snabbt affärskritisk. Om datan inte är dokumenterad, licensierad eller på annat sätt säkrad, finns det en konkret risk för framtida tvister. Ännu värre: osäkerheten kan bromsa kapital eller försena lanseringar.

Samtidigt skapas ett potentiellt övertag för svenska bolag som har tillgång till egen, kvalitativ och lagligt insamlad data. Här kan verksamheter inom exempelvis hälso- och sjukvård, industri eller specialistmedia skapa modeller med både lägre juridisk risk och tydligare differentiering.

Framtiden för AI och upphovsrätt

Vad vi vet säkert är att detta bara är början. Kampen om var gränserna ska dras mellan AI-utveckling och upphovsrätt kommer att fortsätta, och slutresultatet kommer troligtvis att forma hur vi använder och utvecklar AI-teknologi under många år framöver. För tillfället har AI-företagen fått lite andrum, men frågan är långt ifrån avgjord.

Källor

Läs mer om Disney’s försök att stämma Midjourney här på Techies.se